😎 공부하는 징징알파카는 처음이지?

모델 매개변수 최적화 [옵티마이저, 손실함수, 하이퍼파라미터] 본문

220922 작성

<본 블로그는 pytorch, sswwd 님의 블로그를 참고해서 공부하며 작성하였습니다 :-) >

https://tutorials.pytorch.kr/beginner/basics/optimization_tutorial.html

모델 매개변수 최적화하기

파이토치(PyTorch) 기본 익히기|| 빠른 시작|| 텐서(Tensor)|| Dataset과 Dataloader|| 변형(Transform)|| 신경망 모델 구성하기|| Autograd|| 최적화(Optimization)|| 모델 저장하고 불러오기 이제 모델과 데이터가 준비

tutorials.pytorch.kr

하이퍼파라미터 튜닝이란?(1)

네트워크를 구성할 때 사람이 조정해야 하는 파라미터가 존재한다. 이를 하이퍼파라미터라고 한다. 하이퍼파라미터 : - 은닉층 수, 은닉층의 채널 수 → 예 : model.add(Dense(128)) - drop out 비율 - 활성

sswwd.tistory.com

모델이 준비되었으면! 데이터에 매개변수를 최적화 해야 한다!

그런다음 모델 학습 -> 검증 -> 테스트

이 때

에폭(epoch) 각 반복 단계에서 모델은 출력을 추측하고, 추측과 정답 사이의 오류(손실(loss))를 계산

매개변수에 대한 오류의 도함수(derivative)를 수집한 뒤,

경사하강법을 사용하여 이 파라미터들을 최적화(optimize)

💚 하이퍼파라미터(Hyperparameter)

: 모델 최적화 과정을 제어할 수 있는 조절 가능한 매개변수

- 에폭(epoch) 수 : 데이터셋을 반복하는 횟수

- 배치 크기(batch size) : 매개변수가 갱신되기 전 신경망을 통해 전파된 데이터 샘플의 수

- 학습률(learning rate) : 각 배치/에폭에서 모델의 매개변수를 조절하는 비율

- 값이 작을수록 학습 속도가 느려짐

- 값이 크면 학습 중 예측할 수 없는 동작이 발생

💚 손실 함수(loss function)

: 획득한 결과와 실제 값 사이의 틀린 정도(degree of dissimilarity)를 측정, 학습 중에 이 값을 최소화

: 주어진 데이터 샘플을 입력으로 계산한 예측과 정답(label)을 비교하여 손실(loss)을 계산

- 회귀 문제(regression task)

- nn.MSELoss(평균 제곱 오차(MSE; Mean Square Error))

- 분류(classification)

- nn.NLLLoss (음의 로그 우도(Negative Log Likelihood))

- nn.LogSoftmax와 nn.NLLLoss를 합친 nn.CrossEntropyLoss

💚 옵티마이저(Optimizer)

: 최적화 알고리즘은 각 학습 단계에서 모델의 오류를 줄이기 위해 모델 매개변수를 조정

: 모든 최적화 절차(logic)는 optimizer 객체에 캡슐화(encapsulate)

: PyTorch에는 ADAM이나 RMSProp 등

- optimizer.zero_grad() : 모델 매개변수의 변화도를 재설정

- 기본적으로 변화도는 더해지기 때문에 중복 계산을 막기 위해 반복할 때마다 명시적으로 0으로 설정

- loss.backwards() : 예측 손실(prediction loss)을 역전파

- PyTorch는 각 매개변수에 대한 손실의 변화도를 저장

- optimizer.step() : 역전파 단계에서 수집된 변화도로 매개변수를 조정

💚 은닉층

: 네트워크 구조(은닉층 수, 은닉층의 유닛 수)는 자유롭게 설정

: 수를 많게 하면 다양한 함수를 표현할 수 있음

BUT, 입력층에 가까운 가중치를 적절하게 갱신하기 어렵고 학습이 좀처럼 진행되지 않음

중요성이 낮은 특징량을 추출해버려 과학습하기 쉬워짐

💚 Drop out

: 과학습을 방지하여 모델의 정확도를 높이는 방법 중 하나

: 유닛의 일부가 학습할 때마다 0으로 덮어쓰기 되어 무작위로 제거된

: 신경망은 특정 뉴런의 존재에 의존할 수 없게 되어 train data외에도 통용되기 쉬운 특징을 학습

: 드롭아웃을 사용하는 위치, 인수 rate는 모두 하이퍼파라미터다.

: drop out은 훈련하는 동안에만 활성화되므로 훈련 손실과 검증 손실을 비교하면 오해를 일으키기 쉬움

=> drop out을 빼고 훈련 손실을 평가

💚Activation(활성화 함수)

: 전결합층 뒤에 적용하는 함수로, 뉴런의 발화에 해당

: 사용하지 않을 경우 단일 직선으로 분리할 수 없는(선형 분리가 불가능한) 데이터는 분류할 수 없음

=> 모델에 비선형성을 갖게 하여 선형 분리 불가능한 데이터에 대응하기 위해 activation을 사용

▶ Sigmoid

- 시그모이드 함수는 반드시 0과 1사이의 구간에 값이 들어가기 때문에 극단적인 출력값이 적음

- 리턴 값이 확률 값이기 때문에 결과를 확률로 해석할 때 유용

- 입력값이 모두 양수일 경우 파라미터의 모든 부호는 같음

- gradient descent시 정확한 방향으로 가지 못하고 지그재그로 발산하는 문제가 발생(= 학습이 느려짐)

- 음수 값을 0에 가깝게 표현하기 때문에 입력 값이 최종 레이어에서 미치는 영향이 적어지는 Vanishing Gradient Problem이 발생

- x의 절대값이 커질수록 미분 값이 소실될 가능성이 큶

▶ Tanh

- 출력은 -1에서 1사이 구간으로 제한

- 중심점을 0으로 옮겨 sigmoid가 갖고 있던 최적화 과정에서 느려지는 문제를 해결

- BUT Vanishing Gradient Problem은 여전히 남아있음

- RNN, LSTM 등을 학습시킬 때 사용

▶ ReLU(Rectified Linear Unit)

- 가장 많이 사용되는 activation

- 출력이 어떤 구간에도 수렴되지 않고, 극단적인 출력값이 생성될 가능성이 있음

- Vanishing Gradient Problem 해결하기 위한 함수

- sigmoid나 tanh와 비교했을 때 SGD의 optimization 속도가 매우 빠름

- relu는 미분값이 0 아니면 1이기 때문에 별다른 비용이 들지 않음

- BUT, 네트워크를 학습시킬 때 뉴런들이 죽는 경우가 발생

- 입력값이 0보다 작으면 뉴런이 죽어 더 이상 값의 업데이트가 수행되지 않음

- 한번 0 활성화 값을 다음 레이어에 전달하면 이후의 뉴런들의 출력값이 모두 0이 되는 현상이 발생

▶ softmax

- 입력받은 값을 0에서 1사이의 값으로 모두 정규화(normalized)하며, 출력 값이 여러개

- 다중 클래스 문제에 적용

- 정규화 기능을 가짐

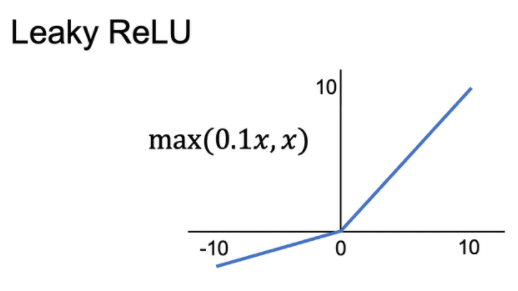

▶ Leaky ReLU

- relu의 죽는 뉴런 현상을 해결하기 위해 제시된 함수

- 작은 기울기(0.01과 같은 매우 작은 값)를 부여

- 입력 값이 음수일 때 완만한 선형 함수를 그려줌

▶ PReLU

- Leaky ReLU와 거의 유사하지만 새로운 파라미터 α 를 추가해 x가 음수인 영역에서도 기울기를 학습

- 음수에 대한 gradient를 변수로 두고 학습을 통하여 업데이트

▶ ELU(Exponential Linear Unit)

- ReLU의 모든 장점을 포함하며 Dying ReLU 문제를 해결

- 출력 값이 거의 zero-centered에 가까우며, 일반적인 ReLU와 다르게 exp 함수를 계산하는 비용이 발생

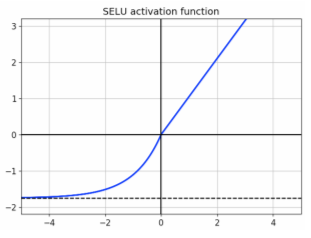

▶ SELU(Scaled ELU)

- ELU 활성화 함수의 변종

- 완전 연결 층만 쌓아서 신경망 만들고 모두 은닉층이 SELU 활성화 함수를 사용하면 네트워크가 자기 정규화가 됨

- 훈련하는 동안 각 층의 출력이 평균 0, 표준편차 1을 유지

- 입력 특성 반드시 표준화 출력이 평균 0, 표준편차 1

- 모든 은닉층의 가중치는 lecun_normal 정규분포 초기화

- 네트워크는 일렬로 쌓은 층으로 구성

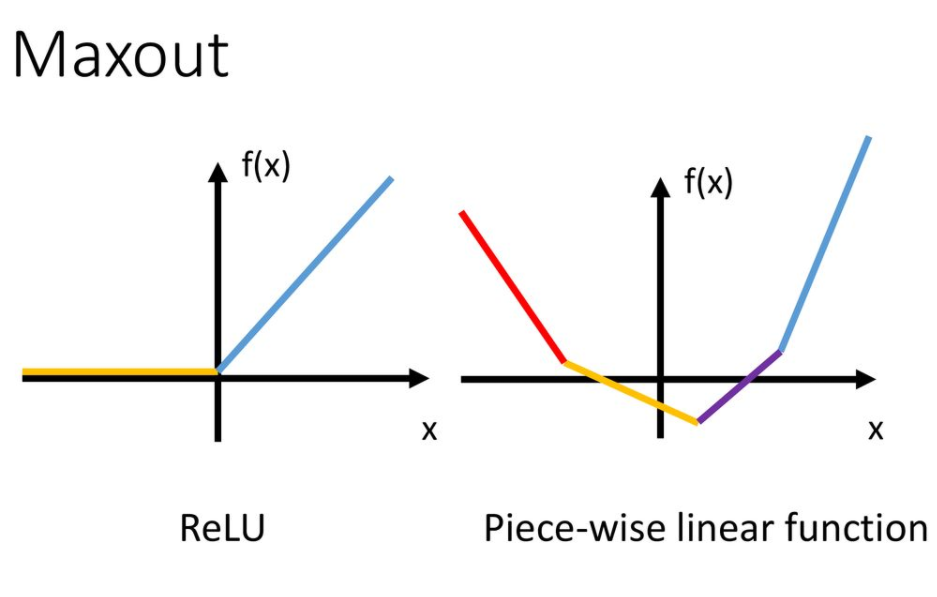

▶ Maxout

- ReLU의 장점을 모두 가지고, Dying ReLU의 문제를 해결

- 계산이 복잡

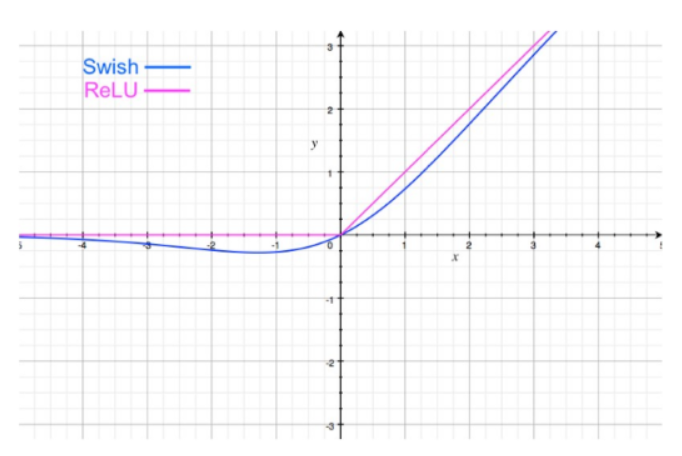

▶ Swish

- 2017년 구글에서 만든 함수

- 시그모이드 함수에 x를 곱한 아주 간단한 형태

- 깊은 레이어를 학습시킬 때 ReLU보다 더 뛰어난 성능을 보임

- ReLU와 달리 Swish는 갑작스러운 동작 또는 정점 변경이 없음

▶ GELU(Gaussian Error Linear Unit)

- 2018년도에 도입

- 비선형 함수

- 네트워크가 깊어질수록 잘 작동

- GELU는 BERT, ROBERTa, ALBERT 및 기타 상위 NLP 모델과 호환

'👩💻 컴퓨터 구조 > etc' 카테고리의 다른 글

| 파이썬 pandas 여러 폴더 내 csv 불러오기 (0) | 2022.12.05 |

|---|---|

| 자바스크립트 slice로 배열 10칸씩 옮기기 with 스케줄링 (0) | 2022.11.18 |

| "Ctrl + Shift + R " & "Ctrl + F5" & "F5" 차이점 (0) | 2022.09.15 |

| 나중에 참고할 코드 소스 (0) | 2022.09.14 |

| windows Ubuntu(Linux)에 Anaconda 연동하기 (0) | 2022.09.02 |