😎 공부하는 징징알파카는 처음이지?

[AI]_21_과학습 막기! 본문

220327 작성

<본 블로그는 두우우부님의 알기쉬운 AI 블로그를 참고해서 공부하며 작성하였습니다>

https://doooob.tistory.com/88?category=825950

[알기쉬운 AI - 21] 과학습을 막는 방법

시작하기 인간에게는 ego와 업보가 있듯이, 기계 학습에게는 과학습 이라는 것이 붙어 다닙니다. 숙명이라고 할 수 있지요. 따라서 최근의 신경망 라이브러리는 과학습을 방지하기 위한 몇 가지

doooob.tistory.com

1. 정규화 (Regularization)

: 과학습의 원인은

특정 학습 데이터로만 학습을 지나치게 해서 미지의 데이터에 대한 오차(일반화 오차)가 역으로 증가해 버리는 것

: 정규화란

"극단적이라 생각되는 의견은 듣지 않는다"

모델을 복잡하게 하는 가중치는 그 양에 따른 페널티를 부여하여 모델이 복잡해지지 않도록 하는 것

- L1 규범 정규화 (Lasso 회귀) : 극단적인 데이터의 가중치를 0으로

- L2 규범 정규화 (Ridge 회귀) : 극단적인 데이터의 가중치를 0에 가깝게

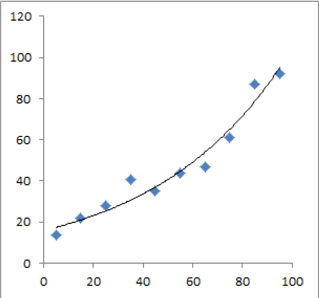

회귀 분석이란?

: '많은 데이터를 펼쳤을 때 그 관계를 나타내는 선(함수)을 찾는 것'

: 선형(1차 함수)로 표시하면 선형 회귀이지만, 2차 이상의 곡선으로 나타날 때는 비선형 회귀로, 그 선을 '회귀 곡선'

norme이란?

: 벡터 공간에서의 거리 개념

: 회귀선과 점과의 거리

Q. 정규화와 일반 회귀의 차이점은?

A. 일반 회귀는 데이터의 오차(플롯 선과의 거리 : norme)를 줄이는 식으로 계산

A. norme의 크기에 관계없이 플롯은 영향도가 같음

A. 정규화는 오차에 따른 페널티(가중치를 0 또는 0에 가깝게)를 부여

=> 일반적인 회귀는 비상식적인 의견도 평등하게 듣는 것

=> 정규화의 경우 거기에 더하여 비상식의 정도에 따라 무시하거나(L1), 반만 듣는(L2)

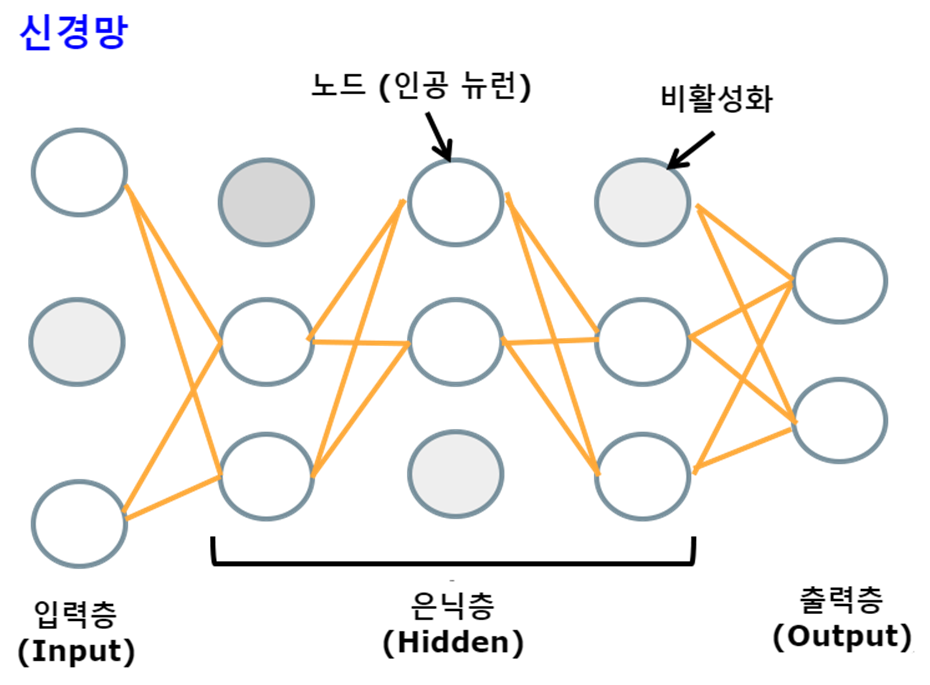

2. 드롭아웃(Drop out)

: "랜덤으로 노드를 비활성화하여 학습" 처리

ex) 회귀 곡선으로 말하면, 플롯을 바탕으로 선을 긋는 대신에 어느 정도 선별된 플롯에 대하여 회귀선을 긋는 것

"기계 학습은 같은 훈련 데이터에서 여러 번 학습을 반복한다는 것"

: 드롭아웃의 원리는 학습 때마다 무작위로 비활성화되는 노드가 선택되기 때문에 실상은 같은데 매번 다른 가중치 적용

앙상블 학습 (Ensemble learning) 이란?

: 개별 학습한 여러 학습기를 융합시켜 일반화 능력을 향상시킨 기계학습 기술

ex) 기계 학습에서 자주 사용되는 랜덤 포레스트는 여러 의사 결정 트리의 결과를 평균화하는 앙상블 학습을 이용한 방법

드롭아웃은?

: 하나의 학습기인데 매번 무작위로 비활성화 노드를 결정하여 허위로 앙상블 학습을 실시하고 있는 것

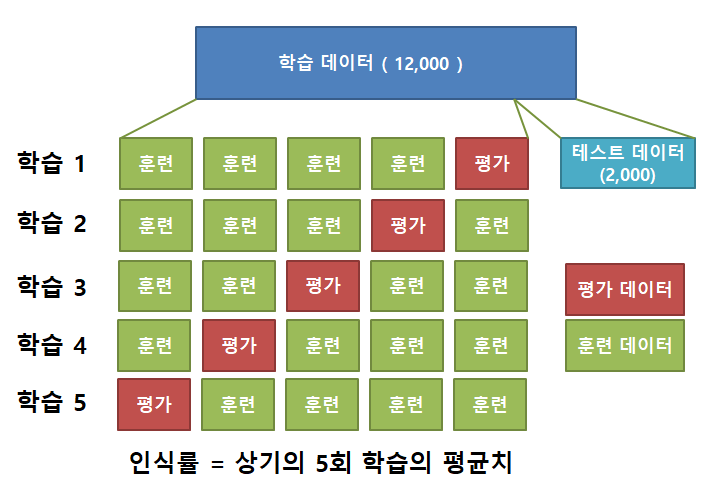

3. K분할 교차 검증(K-fold cross-validation)

: 데이터 집합을 K개로 나누어 각각 학습한 결과를 종합해서 평가하는 것으로 일종의 앙상블 학습

: 평가를 높이기 위해 여러 번 데이터를 돌린 결과(과학습이 되지 않을 정도로) 최고의 평가를 얻은 곳에서 학습 1이 끝남

Q. K 분할 교차 검증은

테스트 데이터는 따로 설정할 필요가 있을까요?

A. "YES"

학습 1 ~ 학습 n의 각 회전마다 평가 데이터 값이 높아지도록 조정하는 것이므로,

마지막에 테스트 데이터로 확인하지 않으면 진정한 성능을 측정할 수 없음

'👩💻 인공지능 (ML & DL) > AI' 카테고리의 다른 글

| [AI]_23_P-Value & Q-Value (0) | 2022.05.08 |

|---|---|

| [AI]_22_강화학습 & 도적 알고리즘 (0) | 2022.05.07 |

| [AI]_20_비정상 과학 학습 (0) | 2022.03.27 |

| [AI]_19_머신 러닝(ML) 학습 데이터 (0) | 2022.03.27 |

| [AI]_18_계층 신경망 (0) | 2022.03.27 |