😎 공부하는 징징알파카는 처음이지?

이상 탐지의 알고리즘 (Anomaly Detection Algorithm) 본문

220927 작성

<본 블로그는 coding-nurse님과 today-1, diging-developer 님의 블로그를 참고해서 공부하며 작성하였습니다 :-) >

https://coding-nurse.tistory.com/294?category=991286

[ML 알고리즘] 이상 탐지(Anomaly Detection) 알고리즘

이상탐지 알고리즘에 대한 내용이 너무 방대하기도 하고, 다 공부하기엔 바쁘다바빠현대사회에 살고있는 나이기에 잘 정리설명을 하는 유튜브강의를 선택하였다! 역시나 좋은 강의 ! 🎥 유튜

coding-nurse.tistory.com

https://today-1.tistory.com/27?category=886697

시계열 및 통계 용어

시계열 및 통계적 용어 : 분석 진행에 앞서 기초적인 용어를 먼저 학습해보자 1. 데이터 관점에 따른 분류 : 시계열 분석 Target data 1) 시계열종단면 : 다수시점 + 특정독립변수 2) 시계열횡단면 : 다

today-1.tistory.com

https://dining-developer.tistory.com/29

시계열 예측을 지도 학습으로 바꾸는 방법 - Time Series to Supervised Learning with Sliding window

슬라이딩 윈도우를 통해 시계열 데이터를 지도학습으로 변형하기 시계열 데이터 예측(Time series forecasting)은 지도 학습(Supervised learning)으로 변형시킬 수 있다. 이번 글에서는 시계열 문제를 시계

dining-developer.tistory.com

1️⃣ 이상 탐지(anomaly detection)

: 일반적인 값과 다른 특이한 값(outlier)나 드문 사건을 탐지하는 기법

2️⃣ 이상 탐지 종류

- 1. Point Anomaly Detection

- 특정 point의 이상치를 감지한다.

- 일반적으로 데이터 내의 outlier 이상치를 감지

- 축적된 시간동안 정적인 점분포에 초점을 둔다

- 2. Contextual anomaly detection

- 연속적인 변화 패턴을 읽어서 이상치를 감지

- 맥락을 고려해서 예상변화와 동떨어진 결과를 탐지

- 주의점: 민감하면 정상인데도 이상탐지가 되고, 둔감하면 비정상인데도 이상탐지를 놓침

- 시계열과 같은 동적인 특성에 초점을 둠

- 3. Collective anomaly detection

- 연관있는 2개 이상의 데이터의 변화를 탐지

- 2개이상의 특징을 비교해서, 1개의 특징 변화에 따라 다른 하나 특징이 예상했던 패턴이 아닌 비정상적 패턴을 가질 때 탐지

3️⃣ 시계열 및 통계적 용어

중심 통계량 : 데이터의 중심 경향을 나타내는 수치

1) 평균(산술/기하/조화/가중) : 표본데이터의 중심 무게

2) 중앙값 : 순서를 가진 표본데이터의 가운데(50%)에 위치한 값

3) 최빈값 : 표본데이터 중 가장 빈번한 값

변동 통계량 : 데이터의 변동성을 나타내는 수치

1) 범위(RANGE) : 최대값과 최소값의 차이

2) 편차(DEV) : 관측값과 평균의 차이

3) 분산(VAR) : 편차 제곱의 합을 데이터의 수로 나눈 값

4) 표준편차(STD) : SQRT(분산)

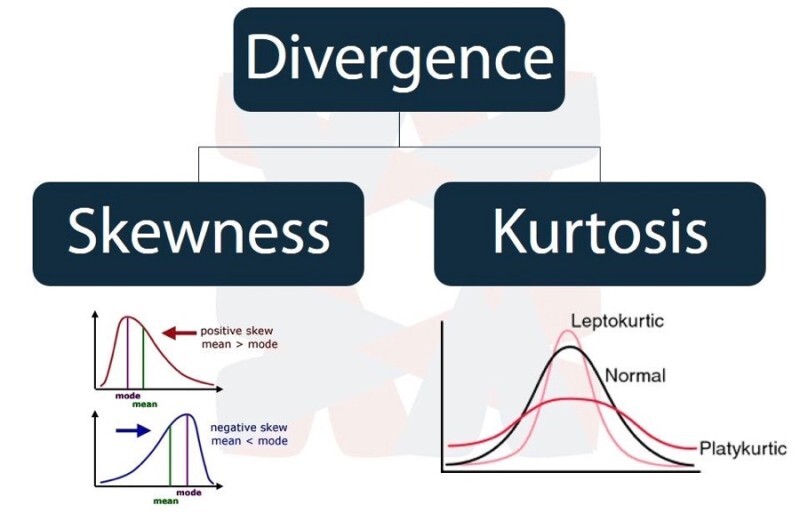

형태 통계량 : 데이터의 분포형태와 왜곡을 나타내는 수치

1) 왜도(Skewness) : 평균을 중심으로 좌우로 데이터가 편향되어 있는 정도

2) 첨도(Kurtosis) : 뾰족함 정도 (첨도가 크면 이상치가 크다)

3) 이상치(Outlier) : 오류로 판단하는 값이지만 기준이 불명확

4️⃣ 시계열 데이터 예측(Time series forecasting)은 지도 학습(Supervised learning)으로 변형

y = f(X)

- 지도 학습 (Supervised Machine Learning)

- 입력(X)과 출력(y) 있음

- 학습된 모델을 바탕으로 학습에 쓰이지 않은 새로운 입력 데이터(X)에 대해서 출력(y)을 잘 예측할 수 있도록 하는 것

- training 데이터셋을 통해 정답을 알고 그 방향으로 지도되는 방식으로 학습되기 때문에 지도 학습

- Classification(분류) : 예측할 값이 카테고리인 경우

- Regression(회귀) : 예측할 값이 실제 값인 경우

- 슬라이딩 윈도우 (Sliding Window)

- 시계열 데이터는 지도 학습으로 표현 가능

- 이전 시간의 데이터를 입력(X)으로 사용하고 다음 시간 데이터를 출력(y)으로 사용하면 됨

- 다단계 예측에서의 슬라이딩 윈도우 (Sliding Window with Multi-Step Forecasting)

- 예측할 미래 단계수는 중요하다.

- One-Step Forecast (1단계 예측) : 단순히 다음 시간 (t+1) 만 예측

- Multi-Step Forecast (다단계 예측) : 여기서 두 단계 이상의 미래 시간 (t+1 ~ t+N) 을 예측

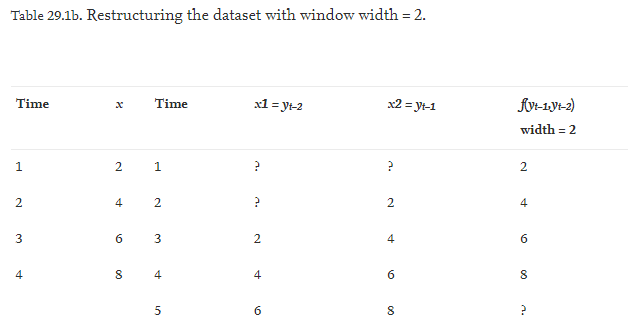

5️⃣ 시간 데이터 분석을 위한 슬라이딩 윈도우 기법

: 시계열 데이터가 많지 않을때 데이터셋을 늘리기 위해 사용하며 window size는 시계열 데이터의 특성을 고려하여 설정함

: y = f (x) 로 설명할 수 있는 시계열 데이터 세트가 주어지면 슬라이딩 윈도우를 사용하여 데이터가 재구성되어 이전 출력 또는 과거 데이터를 사용하여 다음 출력을 예측

- 슬라이딩 윈도우를 관리하기 위한 변수

- window_start : 슬라이딩 윈도우 시작 인덱스

- window_end : 슬라이딩 윈도우 끝 인덱스

- window_sum : 슬라이딩 윈도우 합계

- 하위 윈도우의 범위 k 와 동일하게 유지하며 범위 내의 요소는 모두 합산하고 범위 밖으로 벗어난 요소들은 빼줌

- 슬라이딩 윈도우의 범위가 k 보다 커질때까지 (window_end>=k-1)는 요소들을 합산하기만 하고 이후부터는 범위 밖의 요소들을 차감

- 기존처럼 매번 서브배열의 합계를 구할 필요 없이 모든 요소를 1번만 순회하면서 최대값을 구하게 되므로 빠르고 효율적으로 처리

'👩💻 인공지능 (ML & DL) > Serial Data' 카테고리의 다른 글

| 시계열 데이터(Serial data) 전처리 하기 (2) (0) | 2022.09.27 |

|---|---|

| 시계열 데이터(Serial data) 전처리 하기 (1) (0) | 2022.09.27 |

| VSCode 에 Dash 실행하기 (0) | 2022.09.27 |

| 시계열 데이터란(Time Serial) (2) | 2022.09.26 |

| Prophet을 이용한 기아 자동차 주가 예측하기 (1) | 2022.09.26 |