😎 공부하는 징징알파카는 처음이지?

[Deep Learning]_1_머신러닝 수학 본문

220128 작성

<본 블로그는 두우우부님의 딥러닝 입문 블로그를 참고해서 공부하며 작성하였습니다>

https://doooob.tistory.com/189

[딥러닝 입문 - 2] 머신 러닝에 사용되는 수학

다음 장부터 3회에 걸쳐 딥러닝을 포함한 머신 러닝에 필요한 수학의 기초로 '미분', '선형 대수학', '확률 통계'의 3가지에 대한 요점을 짧게 소개하겠습니다. 그 전에, 이 장에서는 기계 학습(mach

doooob.tistory.com

1. 기계 학습이란?

: 주어진 데이터에서 알 수 없는 데이터에 대하여 특정 규칙이나 패턴을 추출하고, 이를 바탕으로 미지의 데

이터를 분류하거나 예측

2. 지도 학습

: 문제에 대한 답이 있고, 예상된 응답과 실제 응답의 간극이 작아진다

AI ·

인공지능/딥러닝 Tutorial

: 주어진 데이터에서 관계를 예상하며 미지의 데이터에 대해 좋은 전망 세우기

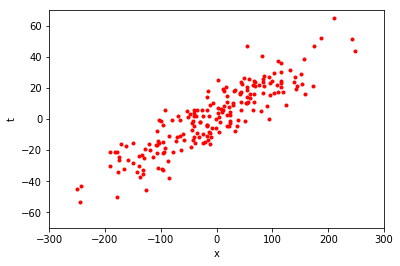

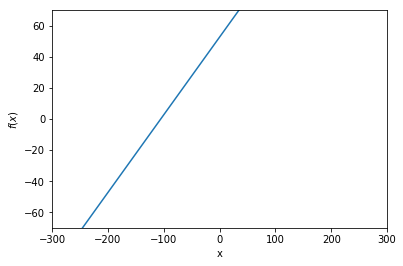

2.1 직선에 의한 근사

: input x 가 주어지면 하나의 출력을 반환

: 기울기 w 와 절편 b 의 두개 파라미터로 이뤄짐

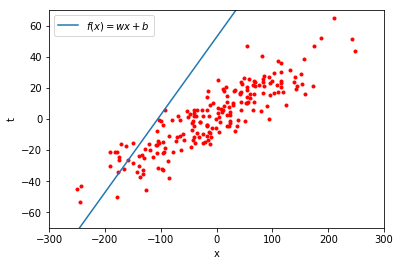

: 겹쳐 보면 음 별로 관계가 이뻐보이지 않는다

: w과 b를 잘 결정하여 빨간 점에 최대한 근접한 직선을 찾을 수 있다면 새로운 x 가 주어질 때 t 값 예측 가능

=> 미지의 데이터에 대해서 정밀하게 예측이 가능한 것을 일반화 성능(generalizability)이 높다

: 매개변수를 사용하여 어떤 계산을 실시, 즉 주어진 데이터의 특징과 관계성을 나타내는 것을 모델(model)이라 부르자

2.2 목적 함수

: 좋은 파라미터를 자동으로 찾아내기 위해서는 무엇이 좋은 매개 변수인가 ! 지표를 정의

: 지표를 나타내는 함수를 목적 함수(objective function)

f(x) = wx + b

: x 를 입력 변수 (input variable)

: y 를 출력 변수 (output variable)

: 식에 주어진 구체적인 x 값을 입력값 (input value)

: 매개 변수 x, b 를 이용한 계산 결과로 얻어지는 구체적인 y 값을 예측값 (predicted value)

: 빨간 점이 갖는 t, 예측하고자하는 목표값 (target value)

=> 목적함수는 모델의 예측값과 목표값을 받고 그 사이의 차를 측정하여 반환

=> 차이가 작을 수록 모델의 예측이 맞다 ( 최소화하는 파라미터 찾기 )

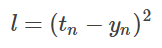

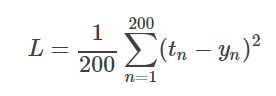

2.3 제곱 오차 함수

ex) 좌표값 (x, t) 를 200 개 있다

x1, x2, --- x200 (입력값) 에서 t1, t2, --- t200 (목표값) 을 예측해야함

: f(x) = wx + b에 의한 예측치 y를 계산한 결과, y1, y2, ---, y200 얻음

: 예측치의 정확도를, 해당 목표값 사이의 차이의 의해 측정 => 제곱 오차 함수 (squared error function)

: n 개의 예측값을 yn, 목표치를 tn 이라 하면

: 많은 데이터에 대해 예측을 하기 위해서는 제곱 오차를 합하고 평균으로 판단

=> 평균 제곱 오차 (mean squared error) : 연속 값을 예측 (회귀에서 많이 쓰임)

: 예측 값과 목표 값이 모두 n에서 완전히 일치할 때 0, 그외 반드시 양수

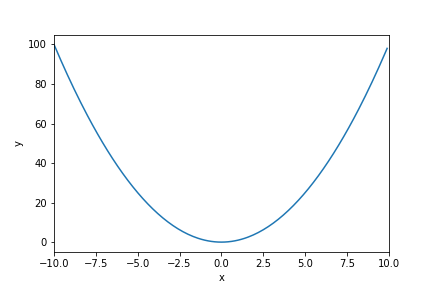

2.4 목적 함수 최적화

: 함수를 최소화하는 입력 변수값을 구하는 것을 최적화

2.5 기계 학습에 사용되는 수학

: 최적화를 수행하는데 필요한 것은 미분 (differential)

: 입력값을 얼마나 움직이면 출력값이 작아질까~~~??

'👩💻 인공지능 (ML & DL) > ML & DL' 카테고리의 다른 글

| [DEEPNOID 원포인트레슨]_10_GAN (0) | 2022.01.28 |

|---|---|

| [DEEPNOID 원포인트레슨]_9_AutoEncoder & GAN (0) | 2022.01.28 |

| [DEEPNOID 원포인트레슨]_8_Reinforcement Learning (0) | 2022.01.27 |

| [DEEPNOID 원포인트레슨]_7_Object Detection 2 (0) | 2022.01.27 |

| [DEEPNOID 원포인트레슨]_6_Segmentation 1. U-Net, attention (0) | 2022.01.26 |